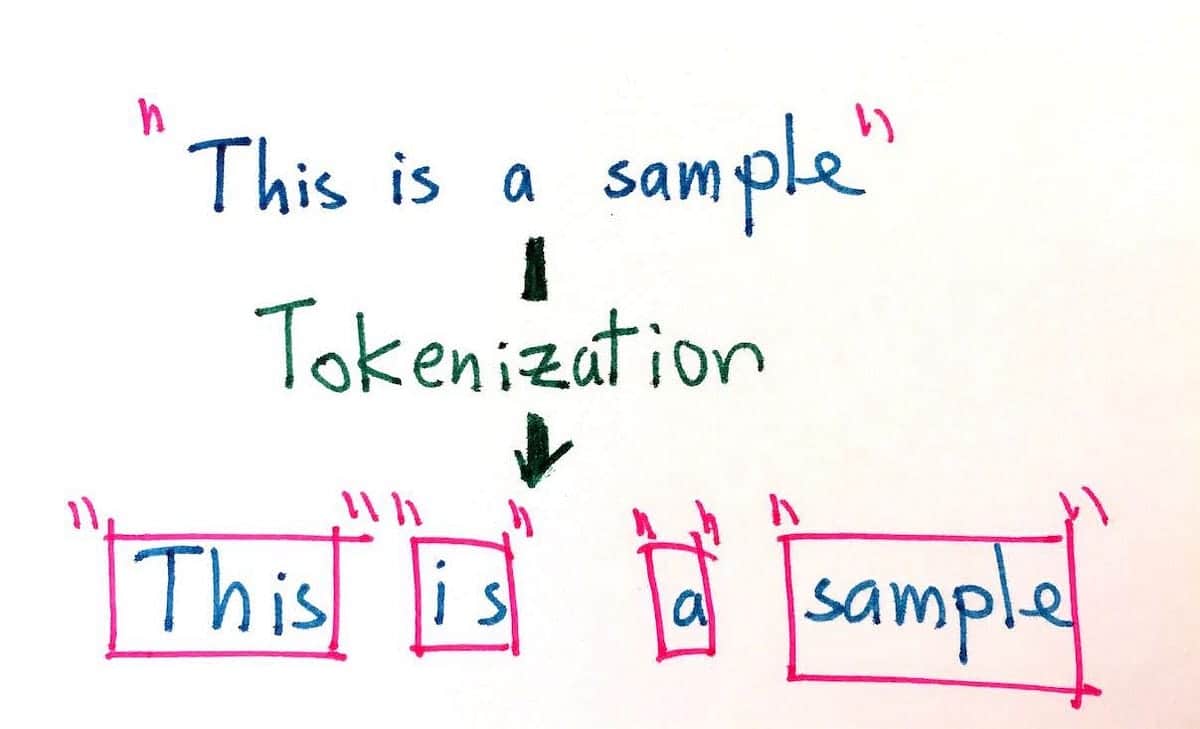

¿Qué es la tokenización?

La tokenización consiste en dividir un texto en entidades más pequeñas llamadas tokens. Los tokens son cosas distintas según el tipo de tokenizador que se utilice. Un token puede ser una palabra, un carácter o una subpalabra (por ejemplo, en la palabra inglesa "higher", hay 2 subpalabras: "high" y "er"). Los signos de puntuación como "!", "." y ";" también pueden ser fichas.

La tokenización es un paso fundamental en toda operación de Procesamiento del Lenguaje Natural. Dadas las diversas estructuras lingüísticas existentes, la tokenización es diferente en cada idioma.

¿Qué es la lematización?

La lematización consiste en extraer la forma básica de una palabra (típicamente la que se puede encontrar en un diccionario). Por ejemplo, el lema de "manzana" seguiría siendo "manzana", pero el lema de "es" sería "ser".

La lematización, al igual que la tokenización, es un paso fundamental en toda operación de Procesamiento del Lenguaje Natural. Dadas las diversas estructuras lingüísticas existentes, la lematización es diferente en cada lengua.