Introducción al LLaMA 3

Meta ha presentado las versiones iniciales de su modelo de IA de código abierto Llama 3, que puede utilizarse para la creación de textos, programación o chatbots. Además, Meta ha anunciado sus planes de incorporar LLaMA 3 a sus principales aplicaciones de redes sociales. Este movimiento pretende competir con otros asistentes de IA, como ChatGPT de OpenAI, Copilot de Microsoft y Gemini de Google.

Al igual que Llama 2, Llama 3 destaca por ser un gran modelo lingüístico de libre acceso con pesos abiertos, ofrecido por una empresa líder en IA (aunque no se puede calificar de "código abierto" en el sentido convencional).

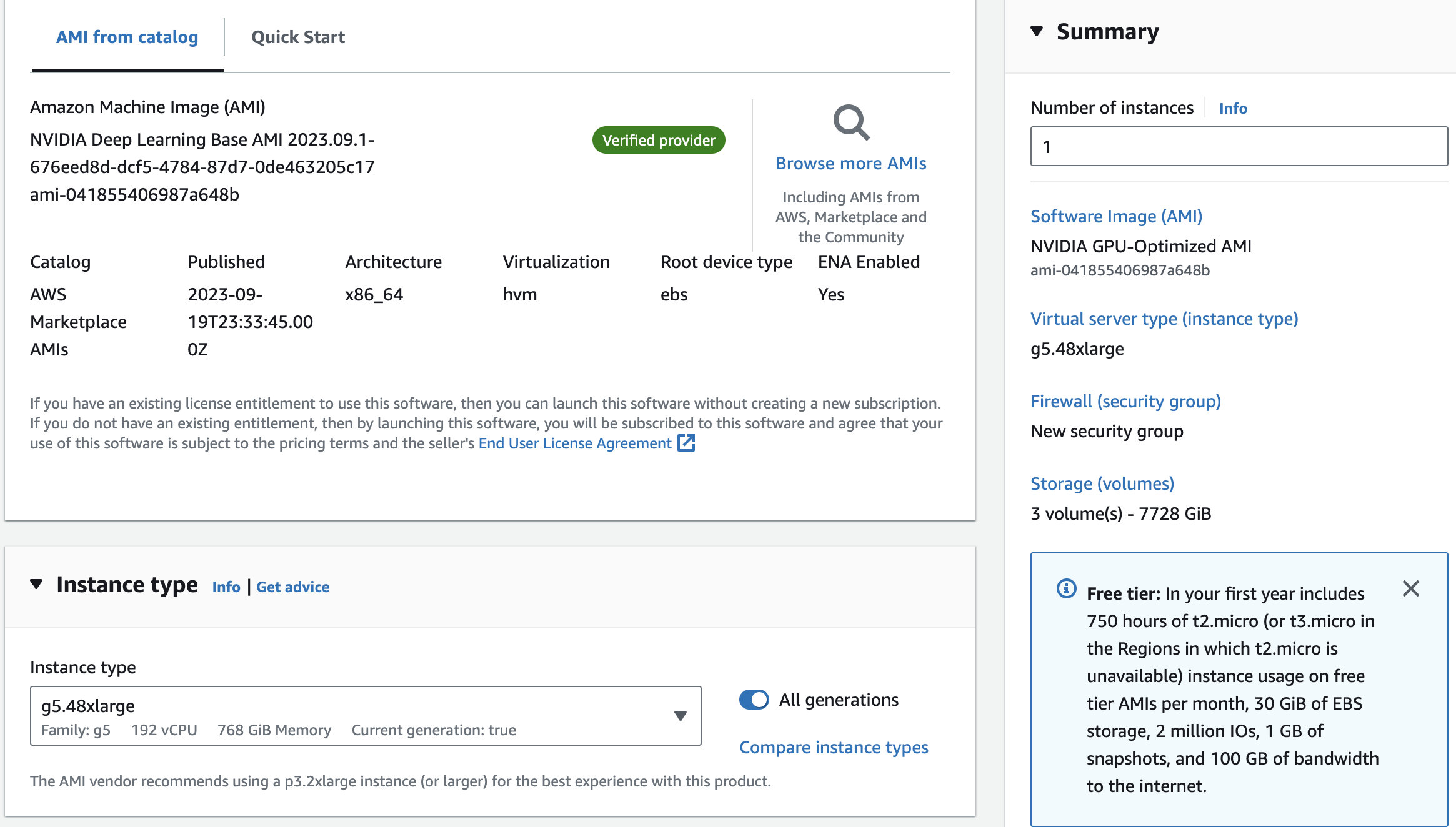

Actualmente, Llama 3 puede descargarse gratuitamente desde el sitio web de Meta en dos tamaños de parámetros diferentes: 8.000 millones (8B) y 70.000 millones (70B). Los usuarios pueden registrarse para acceder a estas versiones. Llama 3 se ofrece en dos variantes: preentrenada, que es un modelo básico para la predicción del siguiente token, y ajustada a instrucciones, que se ajusta con precisión a las órdenes del usuario. Ambas versiones tienen un límite de contexto de 8.192 tokens.

En una entrevista con Dwarkesh Patel, Mark Zuckerberg, CEO de Meta, mencionó que entrenaron dos modelos personalizados utilizando un clúster de 24.000 GPU. El modelo 70B se entrenó con aproximadamente 15 billones de tokens de datos, y nunca alcanzó un punto de saturación o un límite en sus capacidades. Después, Meta decidió centrarse en el entrenamiento de otros modelos. La compañía también ha revelado que actualmente está trabajando en una versión de Llama 3 con parámetros de 400B, que expertos como Jim Fan, de Nvidia, creen que podría tener un rendimiento similar a GPT-4 Turbo, Claude 3 Opus y Gemini Ultra en pruebas como MMLU, GPQA, HumanEval y MATH.

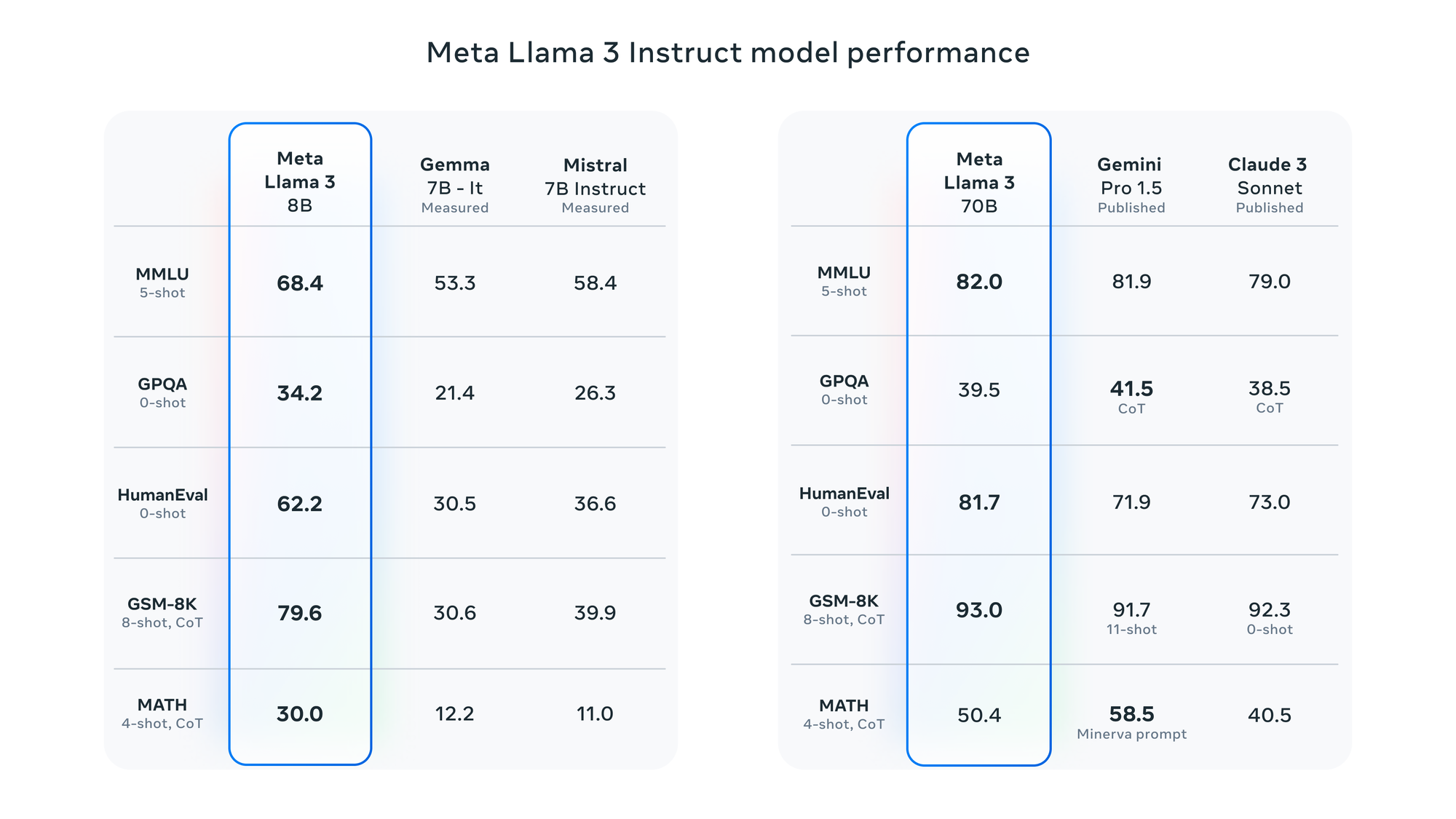

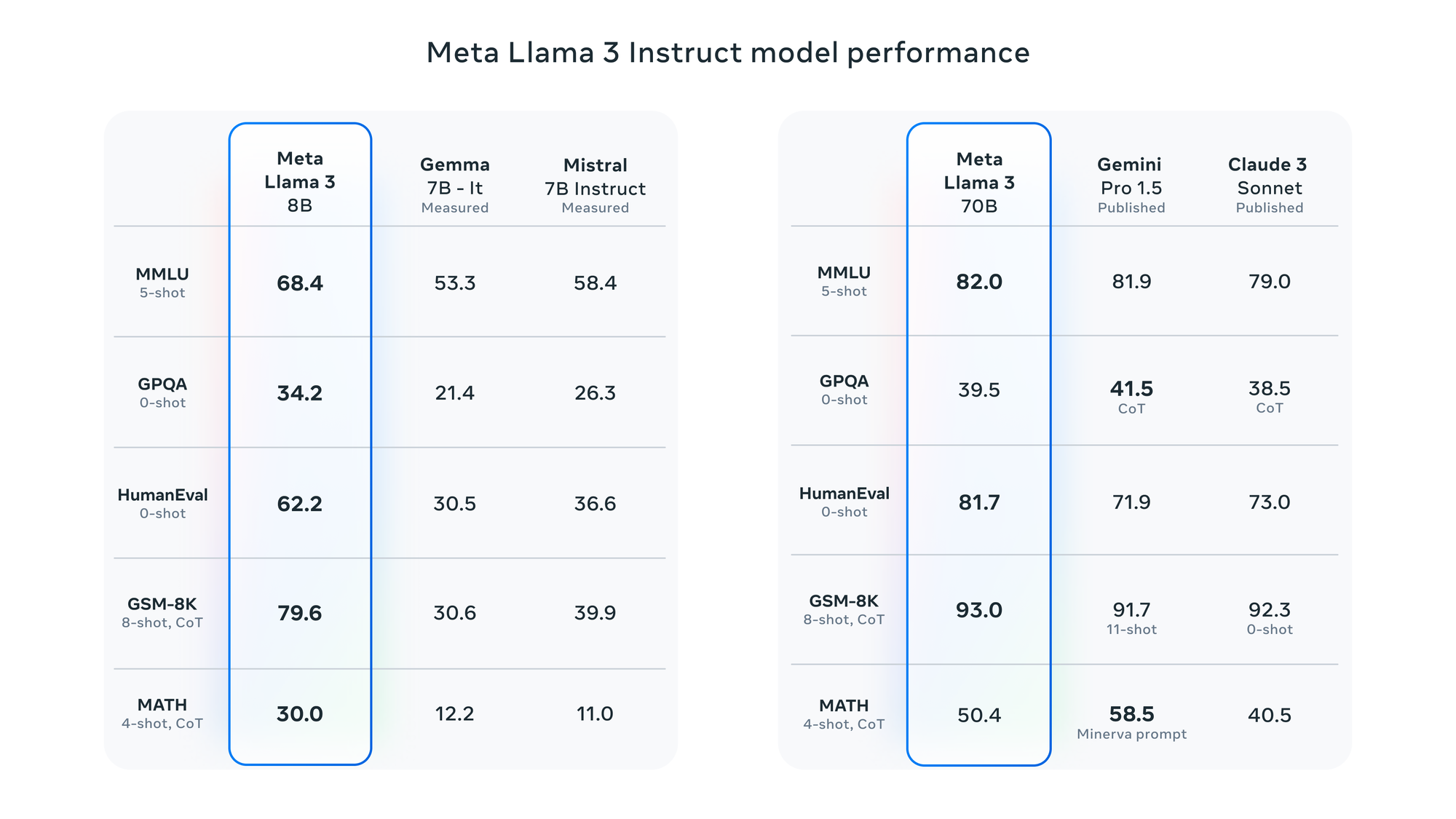

Según Meta, Llama 3 ha sido evaluado utilizando varias pruebas de referencia, como MMLU (conocimientos de nivel universitario), GSM-8K (matemáticas de primaria), HumanEval (codificación), GPQA (preguntas de nivel universitario) y MATH (problemas matemáticos de palabras). Estas pruebas demuestran que el modelo 8B supera a modelos de ponderación abierta como Gemma 7B y Mistral 7B Instruct de Google, y que el modelo 70B es competitivo frente a Gemini Pro 1.5 y Claude 3 Sonnet.

Meta informa de que el modelo Llama 3 se ha mejorado con la capacidad de comprender codificación, similar a Llama 2, y por primera vez se ha entrenado utilizando tanto imágenes como texto. Sin embargo, su rendimiento actual se limita al texto.

Puntos de referencia de LLaMA 3

Puntos de referencia de LLaMA 3