Extracción de entidades con aprendizaje de pocos disparos

Ahora realizaremos la extracción de entidades gracias al aprendizaje de pocos disparos.

Supongamos que quiere extraer los títulos de los puestos de trabajo de los sitios web. Simplemente dé un par de ejemplos de extracción de títulos de trabajo antes de hacer su solicitud real:

Extract job titles from the following sentences.

Sentence: John Doe has been working for Microsoft for 20 years as a Linux Engineer.

Job title: Linux Engineer

###

Sentence: John Doe has been working for Microsoft for 20 years and he loved it.

Job title: none

###

Sentence: Marc Simoncini | Director | Meetic

Job title: Director

###

Sentence: Franck Riboud was born on 7 November 1955 in Lyon. He is the son of Antoine Riboud, who transformed the former European glassmaker BSN Group into a leading player in the food industry. He is the CEO at Danone.

Job title: CEO

###

Sentence: Damien is the CTO of Platform.sh, he was previously the CTO of Commerce Guys, a leading ecommerce provider.

Job title:

El resultado será el siguiente:

Extract job titles from the following sentences.

Sentence: John Doe has been working for Microsoft for 20 years as a Linux Engineer.

Job title: Linux Engineer

###

Sentence: John Doe has been working for Microsoft for 20 years and he loved it.

Job title: none

###

Sentence: Marc Simoncini | Director | Meetic

Job title: Director

###

Sentence: Franck Riboud was born on 7 November 1955 in Lyon. He is the son of Antoine Riboud, who transformed the former European glassmaker BSN Group into a leading player in the food industry. He is the CEO at Danone.

Job title: CEO

###

Sentence: Damien is the CTO of Platform.sh, he was previously the CTO of Commerce Guys, a leading ecommerce provider.

Job title: CTO

Como ya has notado, tenemos que ser inteligentes a la hora de crear nuestros ejemplos de pocos puestos. Puede ocurrir que no se encuentre ningún puesto de trabajo, por lo que hemos creado un ejemplo que devuelve "ninguno" (así se evitan los falsos positivos). ¿Quizás quiera extraer varios títulos de trabajo al mismo tiempo? En ese caso, es importante crear ejemplos que devuelvan varios títulos de trabajo también (títulos de trabajo separados por comas, por ejemplo).

Obtendrá resultados aún mejores si añade más ejemplos. Y es importante que tus ejemplos sean lo más parecidos posible a tu petición final real. Por ejemplo, si sabes que vas a analizar párrafos enteros en lugar de meras frases, lo mejor es que crees también ejemplos con párrafos.

Si no tiene acceso a un modelo GPT, puede simplemente utilizar la API de NLP Cloud. Hay varios clientes disponibles (Python, Go, Node.js, Ruby, PHP...). Vamos a mostrar un ejemplo aquí usando GPT-J con el cliente Python:

import nlpcloud

client = nlpcloud.Client("gpt-j", "your API token", gpu=True)

client.generation("""Extract job titles from the following sentences.

Sentence: John Doe has been working for Microsoft for 20 years as a Linux Engineer.

Job title: Linux Engineer

###

Sentence: John Doe has been working for Microsoft for 20 years and he loved it.

Job title: none

###

Sentence: Marc Simoncini | Director | Meetic

Job title: Director

###

Sentence: Franck Riboud was born on 7 November 1955 in Lyon. He is the son of Antoine Riboud, who transformed the former European glassmaker BSN Group into a leading player in the food industry. He is the CEO at Danone.

Job title: CEO

###

Sentence: Damien is the CTO of Platform.sh, he was previously the CTO of Commerce Guys, a leading ecommerce provider.

Job title:""",

top_p=0.1,

length_no_input=True,

remove_input=True,

end_sequence="###",

remove_end_sequence=True

)

El resultado será: CTO

Permítame darle una explicación rápida sobre los parámetros de generación de texto que acabamos de utilizar.

Establecemos un valor p superior muy bajo porque no queremos que GPT-J cree resultados demasiado originales: sólo queremos que se ciña a lo que vio en su solicitud.

"length_no_input" significa que el valor de la longitud máxima no debe tener en cuenta el texto de entrada.

"remove_input" significa que el texto de entrada debe ser eliminado del resultado.

"end_sequence" significa que cuando el modelo se encuentra con este carácter, debe dejar de generar texto. Como en nuestros ejemplos de pocos disparos añadimos "###" al final de cada respuesta, el modelo generará automáticamente "###" después de generar la respuesta y se detendrá ahí.

"remove_end_sequence" significa que queremos eliminar "###" de la respuesta.

Puede ver más detalles en la documentación de NLP Cloud: véalo aquí.

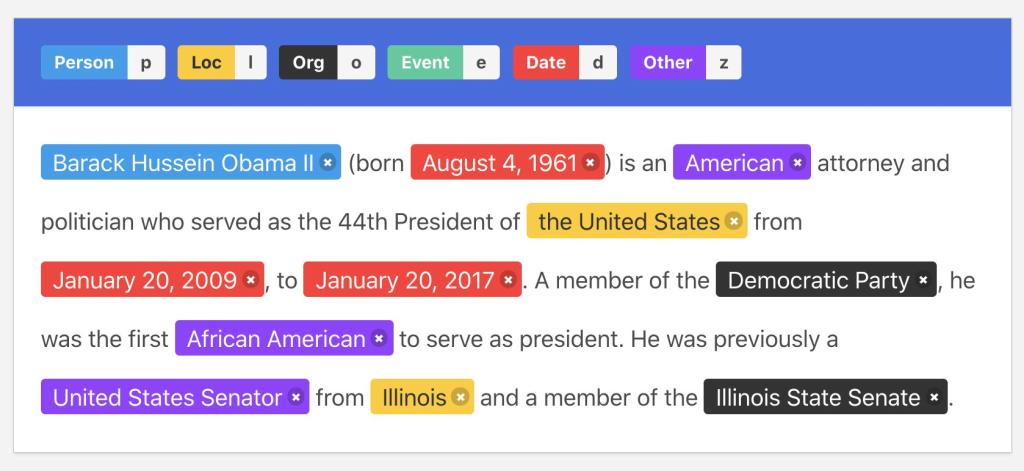

Ilustración de la anotación

Ilustración de la anotación