El poder de GPT-J

Desde su lanzamiento en junio de 2021, GPT-J ha atraído a toneladas de usuarios de NLP -científicos de datos o desarrolladores, que creen que este potente modelo de NLP les ayudará a llevar su aplicación de IA al siguiente nivel (ver el sitio web de EleutherAI).

Logotipo de EleutherAI

GPT-J es tan potente porque se ha entrenado con 6.000 millones de parámetros. La consecuencia es que se trata de un modelo modelo muy versátil que se puede utilizar para casi cualquier caso de uso avanzado de PLN (análisis de sentimientos, clasificación de texto, chatbots, traducción, generación de código, generación de paráfrasis y mucho más). clasificación de texto, chatbots, traducción, generación de código, generación de paráfrasis y mucho más). Cuando está bien ajustado, GPT-J es tan fluido que es imposible decir que el texto ha sido generado por una máquina...

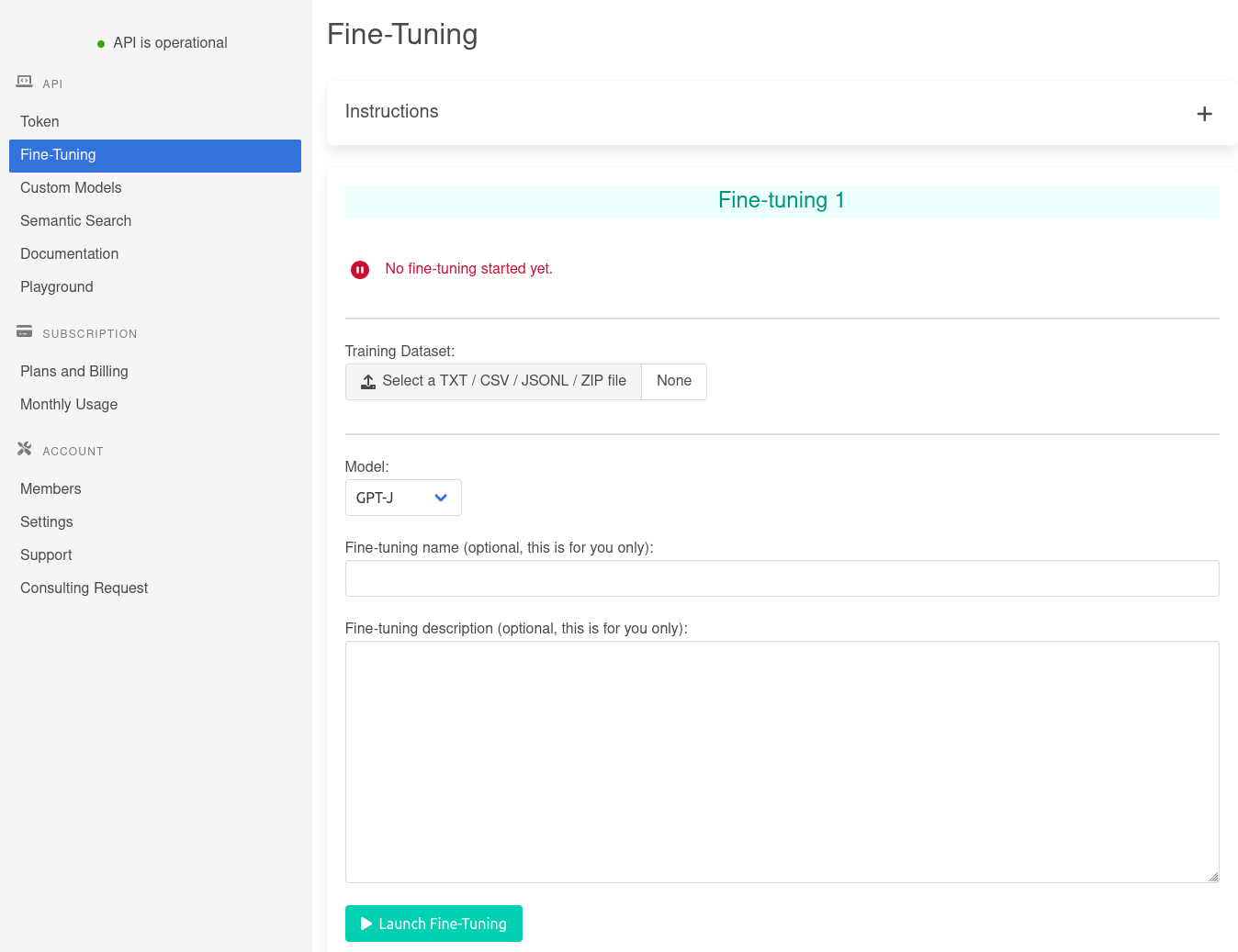

Es posible adaptar fácilmente GPT-J a su caso de uso sobre la marcha mediante la técnica denominada (vea cómo utilizarlo aquí). Sin embargo, si el aprendizaje de unos pocos disparos no es es suficiente, hay que recurrir a una técnica más avanzada: la puesta a punto.