Multi-GPU con Deepspeed

Si no puedes meter tu modelo en una sola GPU, puedes intentar dividirlo en varias GPU.

Es una opción interesante por dos razones. En primer lugar, escalar una infraestructura horizontalmente suele ser más barato que hacerlo verticalmente. Esto es cierto para los servidores y también para las GPU. En segundo lugar, es más fácil hacerse con varias GPUs pequeñas como la NVIDIA Tesla T4 que con GPUs más grandes como la NVIDIA A40.

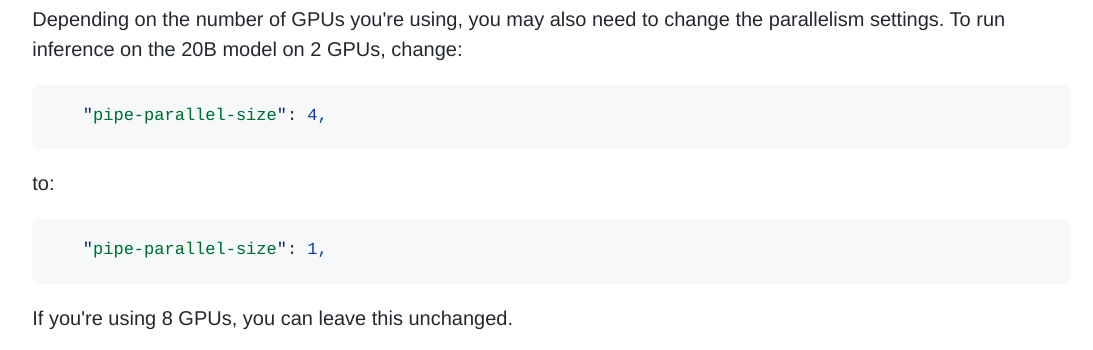

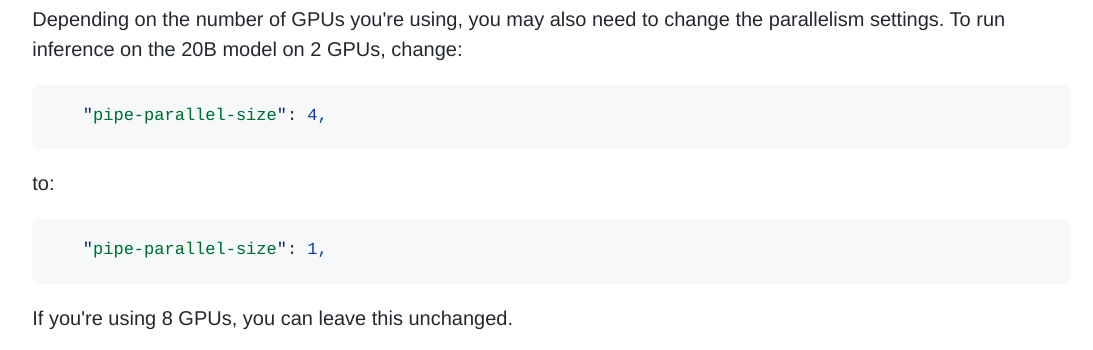

Por desgracia, dividir un modelo de aprendizaje automático en varias GPU es un reto técnico. Hugging Face hizo un gran artículo sobre el paralelismo de modelos y las opciones que tienes. Léelo aquí. Pero por suerte, EleutherAI diseñó la GPT-NeoX 20B de forma que es fácilmente paralelizable en varias GPUs, ya sea para el entrenamiento o la inferencia.

La arquitectura GPT-NeoX se basa en Deepspeed. Deepspeed es un marco de trabajo de Microsoft que se diseñó originalmente para paralelizar los entrenamientos entre varias GPU, y cada vez se utiliza más para la inferencia también. EleutherAI hizo todo el trabajo duro, por lo que paralelizar GPT-NeoX es tan sencillo como cambiar un número en un archivo de configuración.

Extract from the GPT-NeoX docs about parallelism

Sin embargo, desplegar Deepspeed en producción para la inferencia en línea a través de una API es difícil... Deepspeed no fue diseñado para integrarse fácilmente en servidores web. En NLP Cloud, lo aprendimos por las malas, pero después de un arduo trabajo finalmente logramos dar con una forma eficiente de hacer que Deepspeed y GPT-NeoX funcionen detrás de nuestra API.