SpaCy för utvinning av enheter

Den första spaCy-versionen släpptes 2015 och blev snabbt ett standardramverk för utdragning av entiteter (även känt som NER) i företagsklass.

Om du har en ostrukturerad text (t.ex. från webben) och vill extrahera strukturerade data från den, t.ex. datum, namn, platser osv. är spaCy en mycket bra lösning.

SpaCy är intressant eftersom flera förtränade modeller finns tillgängliga på ett 20-tal språk. (se mer här). Det innebär att du inte nödvändigtvis behöver träna en egen modell för att extrahera enheter. Det betyder också att om du vill träna din egen modell kan du utgå från en förtränad modell i stället för att börja från början, vilket kan spara mycket tid.

SpaCy anses vara ett ramverk av "produktionsklass" eftersom det är mycket snabbt, tillförlitligt och har en omfattande dokumentation.

Men om de förvalda enheter som stöds av spaCys förtränade modeller inte räcker till måste du arbeta med "dataannotering" (även känd som "datamärkning") för att kunna träna din egen modell. Den här processen är extremt tidskrävande och många projekt för utdrag av entiteter misslyckas på grund av denna utmaning.

Låt oss säga att du vill extrahera jobbtitlar från en text (t.ex. från ett CV eller från en företagswebb). Eftersom spaCys förtränade modeller inte stöder en sådan enhet som standard måste du lära spaCy att känna igen jobbtitlar. Du måste skapa ett träningsdataset som innehåller flera tusen exempel på utdrag av jobbtitlar (och kanske till och med många fler!). Du kan använda en betald annotationsmjukvara som Prodigy (gjord av spaCy-teamet), men det innebär fortfarande mycket mänskligt arbete. Det är faktiskt ganska vanligt att företag anlitar ett gäng entreprenörer i flera månader för att genomföra ett dataannoteringsprojekt. Ett sådant arbete är så repetitivt och tråkigt att de resulterande datamängderna ofta innehåller många fel ...

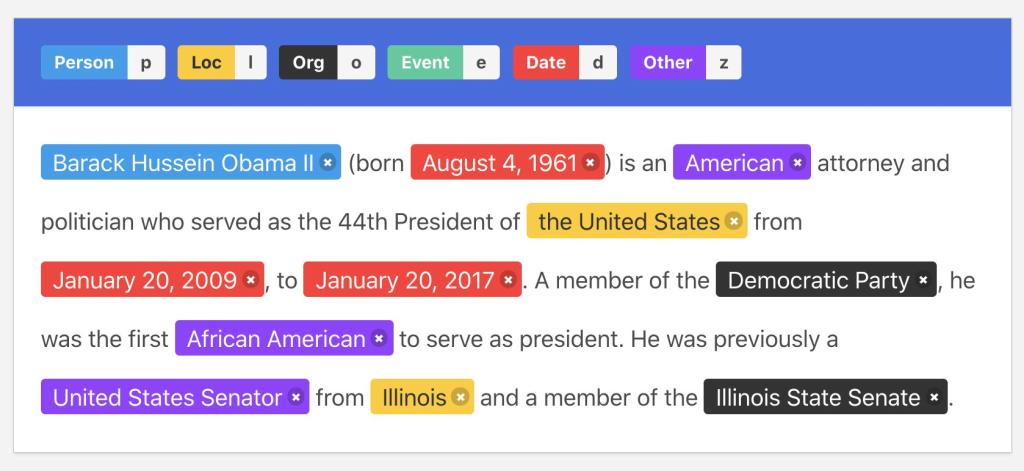

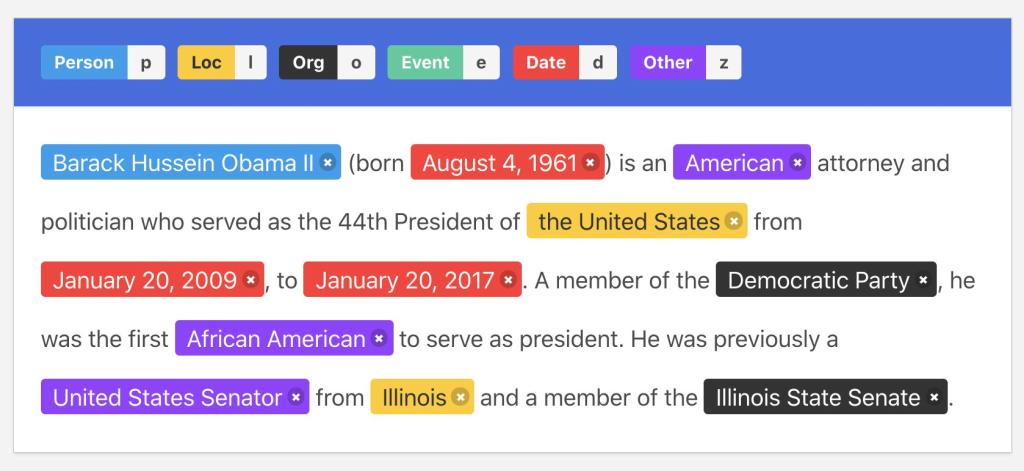

Exempel på dataannotationer

Exempel på dataannotationerLåt oss se vilka alternativa lösningar du kan prova år 2023!