Extraktion av entiteter med inlärning av få skott

Nu kommer vi att utföra utdragning av entiteter med hjälp av inlärning av några få skott.

Låt oss säga att du vill extrahera jobbtitlar från webbplatser. Ge ett par exempel på hur du kan extrahera jobbtitlar innan du gör din egentliga begäran:

Extract job titles from the following sentences.

Sentence: John Doe has been working for Microsoft for 20 years as a Linux Engineer.

Job title: Linux Engineer

###

Sentence: John Doe has been working for Microsoft for 20 years and he loved it.

Job title: none

###

Sentence: Marc Simoncini | Director | Meetic

Job title: Director

###

Sentence: Franck Riboud was born on 7 November 1955 in Lyon. He is the son of Antoine Riboud, who transformed the former European glassmaker BSN Group into a leading player in the food industry. He is the CEO at Danone.

Job title: CEO

###

Sentence: Damien is the CTO of Platform.sh, he was previously the CTO of Commerce Guys, a leading ecommerce provider.

Job title:

Resultatet blir följande:

Extract job titles from the following sentences.

Sentence: John Doe has been working for Microsoft for 20 years as a Linux Engineer.

Job title: Linux Engineer

###

Sentence: John Doe has been working for Microsoft for 20 years and he loved it.

Job title: none

###

Sentence: Marc Simoncini | Director | Meetic

Job title: Director

###

Sentence: Franck Riboud was born on 7 November 1955 in Lyon. He is the son of Antoine Riboud, who transformed the former European glassmaker BSN Group into a leading player in the food industry. He is the CEO at Danone.

Job title: CEO

###

Sentence: Damien is the CTO of Platform.sh, he was previously the CTO of Commerce Guys, a leading ecommerce provider.

Job title: CTO

Som du märkte måste vi vara smarta när det gäller hur vi gör våra exempel med några få skott. Det kan hända att ingen yrkestitel hittas alls, och det är därför vi skapade ett exempel som returnerar "none" (det undviker falska positiva resultat). Kanske vill du extrahera flera jobbtitlar samtidigt? I så fall är det viktigt att skapa exempel som returnerar flera jobbtitlar också (till exempel kommaseparerade jobbtitlar).

Du får ännu bättre resultat om du lägger till ännu fler exempel. Och det är viktigt att dina exempel ligger så nära din slutliga begäran som möjligt. Om du till exempel vet att du kommer att analysera hela stycken i stället för bara meningar, är det bäst att skapa exempel med stycken också.

Om du inte har tillgång till en GPT-modell kan du helt enkelt använda NLP Cloud API. Flera klienter finns tillgängliga (Python, Go, Node.js, Ruby, PHP...). Låt oss visa ett exempel här där vi använder GPT-J med Python-klienten:

import nlpcloud

client = nlpcloud.Client("gpt-j", "your API token", gpu=True)

client.generation("""Extract job titles from the following sentences.

Sentence: John Doe has been working for Microsoft for 20 years as a Linux Engineer.

Job title: Linux Engineer

###

Sentence: John Doe has been working for Microsoft for 20 years and he loved it.

Job title: none

###

Sentence: Marc Simoncini | Director | Meetic

Job title: Director

###

Sentence: Franck Riboud was born on 7 November 1955 in Lyon. He is the son of Antoine Riboud, who transformed the former European glassmaker BSN Group into a leading player in the food industry. He is the CEO at Danone.

Job title: CEO

###

Sentence: Damien is the CTO of Platform.sh, he was previously the CTO of Commerce Guys, a leading ecommerce provider.

Job title:""",

top_p=0.1,

length_no_input=True,

remove_input=True,

end_sequence="###",

remove_end_sequence=True

)

Resultatet kommer att bli: CTO

Låt mig ge dig en snabb förklaring om de parametrar för textgenerering som vi just använde.

Vi har satt ett mycket lågt högsta p-värde eftersom vi inte vill att GPT-J ska skapa alltför originella resultat: vi vill bara att det ska hålla sig till vad det såg i din begäran.

"length_no_input" innebär att det maximala längdvärdet inte ska ta hänsyn till den inmatade texten.

"remove_input" innebär att den inmatade texten ska tas bort från resultatet.

"end_sequence" betyder att när modellen möter detta tecken ska den sluta generera text. Eftersom vi i våra exempel med några få skott har lagt till "####" i slutet av varje svar kommer modellen automatiskt att generera "####" efter att ha genererat svaret och sluta där.

"remove_end_sequence" betyder att vi vill ta bort "####" från svaret.

Mer information finns i dokumentationen för NLP Cloud: se den här.

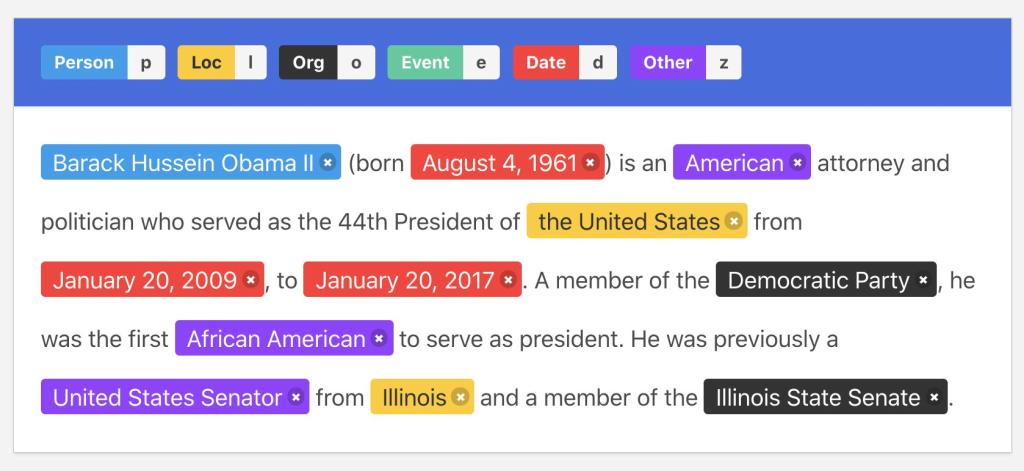

Illustration med kommentarer

Illustration med kommentarer