Kraften i GPT-J

Sedan GPT-J släpptes i juni 2021 har det lockat massor av användare av Natural Language Processing - datavetare - till GPT-J. eller utvecklare - som tror att denna kraftfulla modell för behandling av naturligt språk kommer att hjälpa dem att ta sin AI-applikation till en högre nivå. nästa nivå (se EleutherAI:s webbplats).

EleutherAI:s logotyp

GPT-J är så kraftfull eftersom den har tränats på 6 miljarder parametrar. Konsekvensen är att detta är en mycket mångsidig modell som du kan använda för nästan alla avancerade användningsområden för Natural Language Processing (sentimentanalyser, textanalyser klassificering, chatbots, översättning, kodgenerering, parafrasgenerering och mycket mer). När den är rätt inställd, GPT-J är så flytande att det är omöjligt att säga att texten är genererad av en maskin...

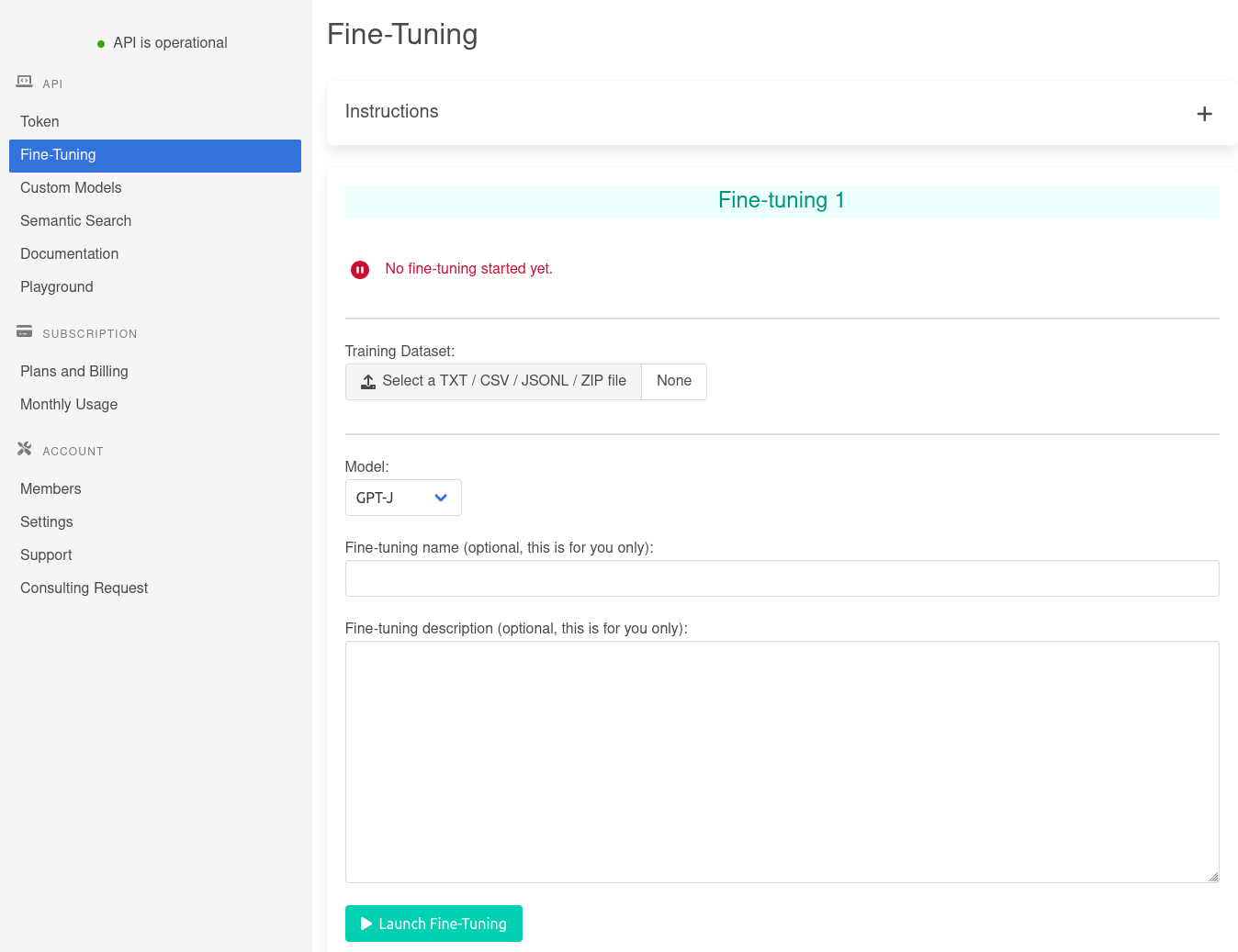

Det är möjligt att enkelt anpassa GPT-J till ditt användningsområde i farten genom att använda den så kallade tekniken (se hur du använder den här). Om inlärning med få skott inte är räcker, måste du välja en mer avancerad teknik: finjustering.