Prissättning: Hugging Face VS NLP Cloud

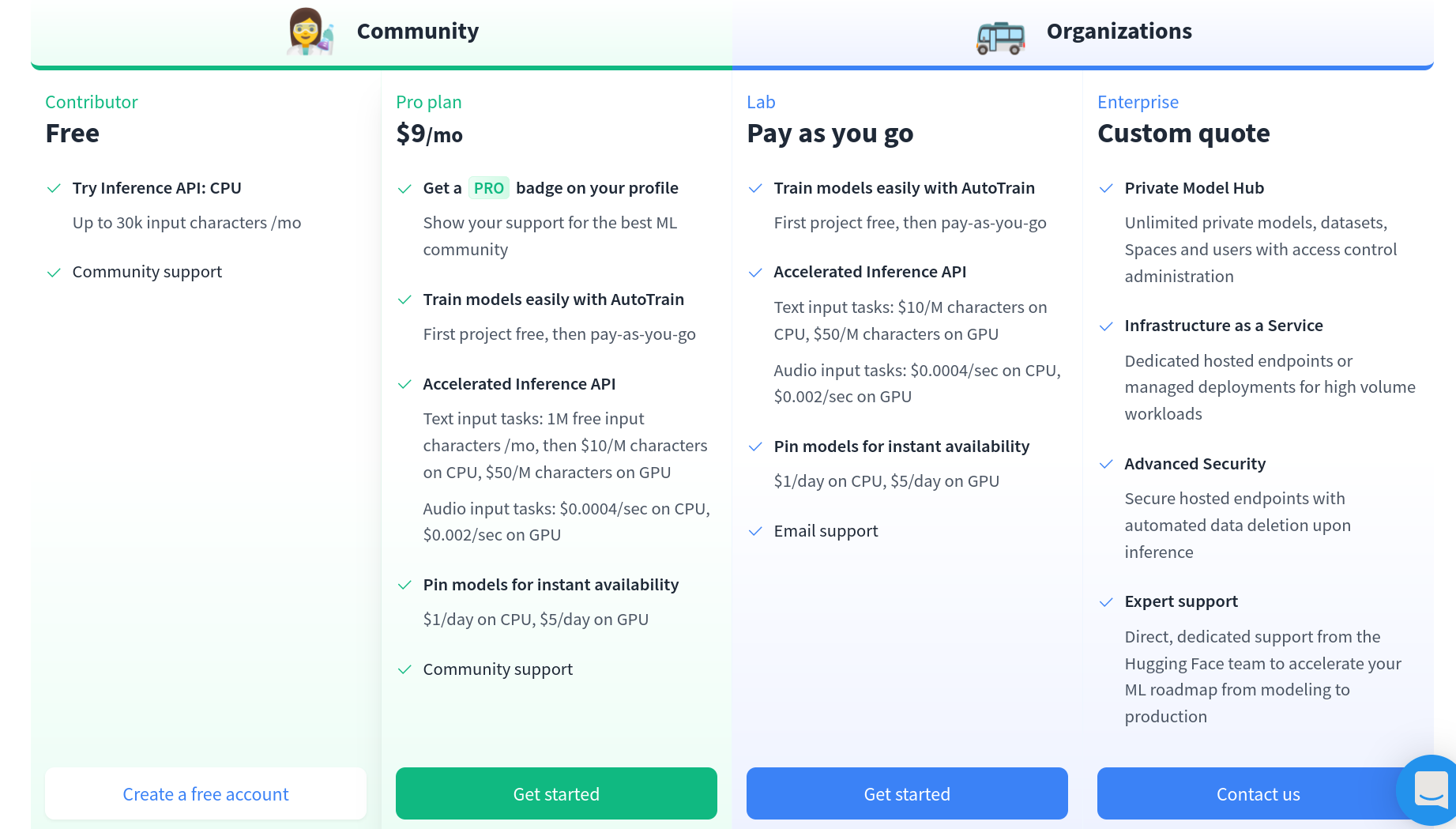

För det första är det värt att notera att NLP Cloud API kan testas gratis när det används på en CPU och en GPU (tack vare den kostnadsfria planen och pay-as-you-go planen som erbjuder 100 000 gratis tokens), medan Hugging Face API endast kan testas gratis på en CPU (tack vare deras kostnadsfria plan). Det är en viktig skillnad eftersom de mest intressanta Transformer-baserade AI-modellerna körs mycket snabbare på en GPU. Vissa går till och med helt enkelt inte att köra på en GPU.

Prissättning av Hugging Face

När det gäller planer erbjuder Hugging Face endast pay-as-you-go prissättning (prissättning baserad på din förbrukning) medan NLP Cloud både erbjuder förbetalda planer och pay-as-you-go planer. Låt oss säga att du vill utföra textklassificering på textstycken som i genomsnitt innehåller cirka 5 000 ord, med en hastighet av 15 förfrågningar per minut, på en GPU. Hugging Face's prissättning baseras på antalet tecken, medan NLP Cloud's prissättning baseras på antalet tokens. 5k ord motsvarar mer eller mindre 15k tecken och 3 750 tokens. På NLP Cloud kostar det dig 99 dollar/månad genom att prenumerera på Starter GPU Plan, medan det på Hugging Face kostar dig 15k x 15 x 60 x 24 x 31 x $50 / 1M = 500k dollar/månad (!!!).

Som du kan se verkar det som om Hugging Face pay-as-you-go-priserna absolut inte lämpar sig för användning i produktionen. Bokstavligen ingen kommer att betala ett sådant pris för textklassificering på en GPU ...

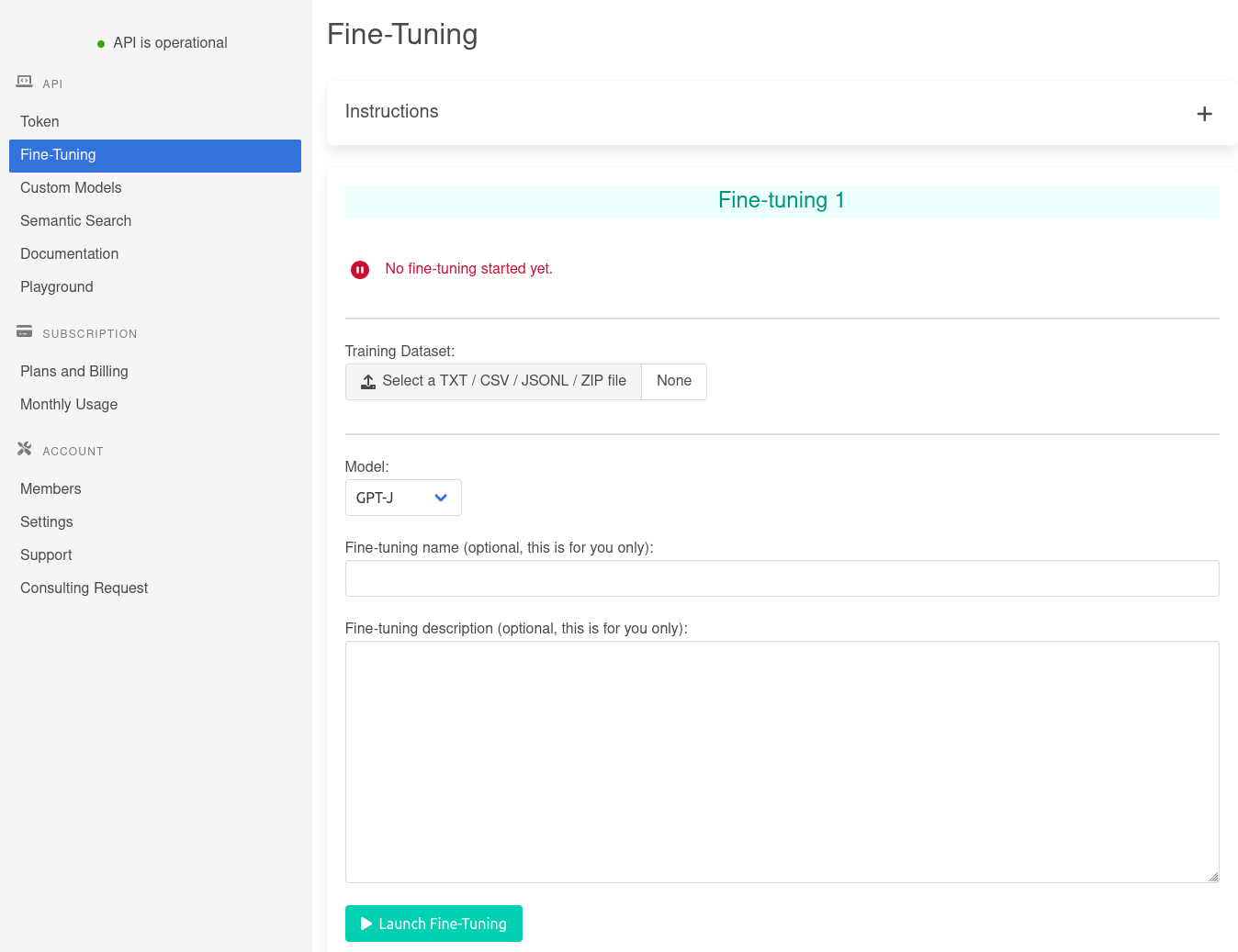

När det gäller finjustering är det inte ens möjligt att jämföra eftersom Hugging Face's AutoTrain-priser inte är offentliga. Vi registrerade oss och provade deras AutoTrain-lösning, men vi kunde fortfarande inte hitta någon tydlig prissättning...