Introduktion till LLaMA 3

Meta har introducerat de första versionerna av sin Llama 3 open source AI-modell, som kan användas för textskapande, programmering eller chatbots. Dessutom tillkännagav Meta sina planer på att införliva LLaMA 3 i sina primära applikationer för sociala medier. Detta drag syftar till att konkurrera med andra AI-assistenter, såsom OpenAI: s ChatGPT, Microsofts Copilot och Googles Gemini.

I likhet med Llama 2 sticker Llama 3 ut som en fritt tillgänglig stor språkmodell med öppna vikter, som erbjuds av ett ledande AI-företag (även om den inte kvalificerar sig som "öppen källkod" i konventionell mening).

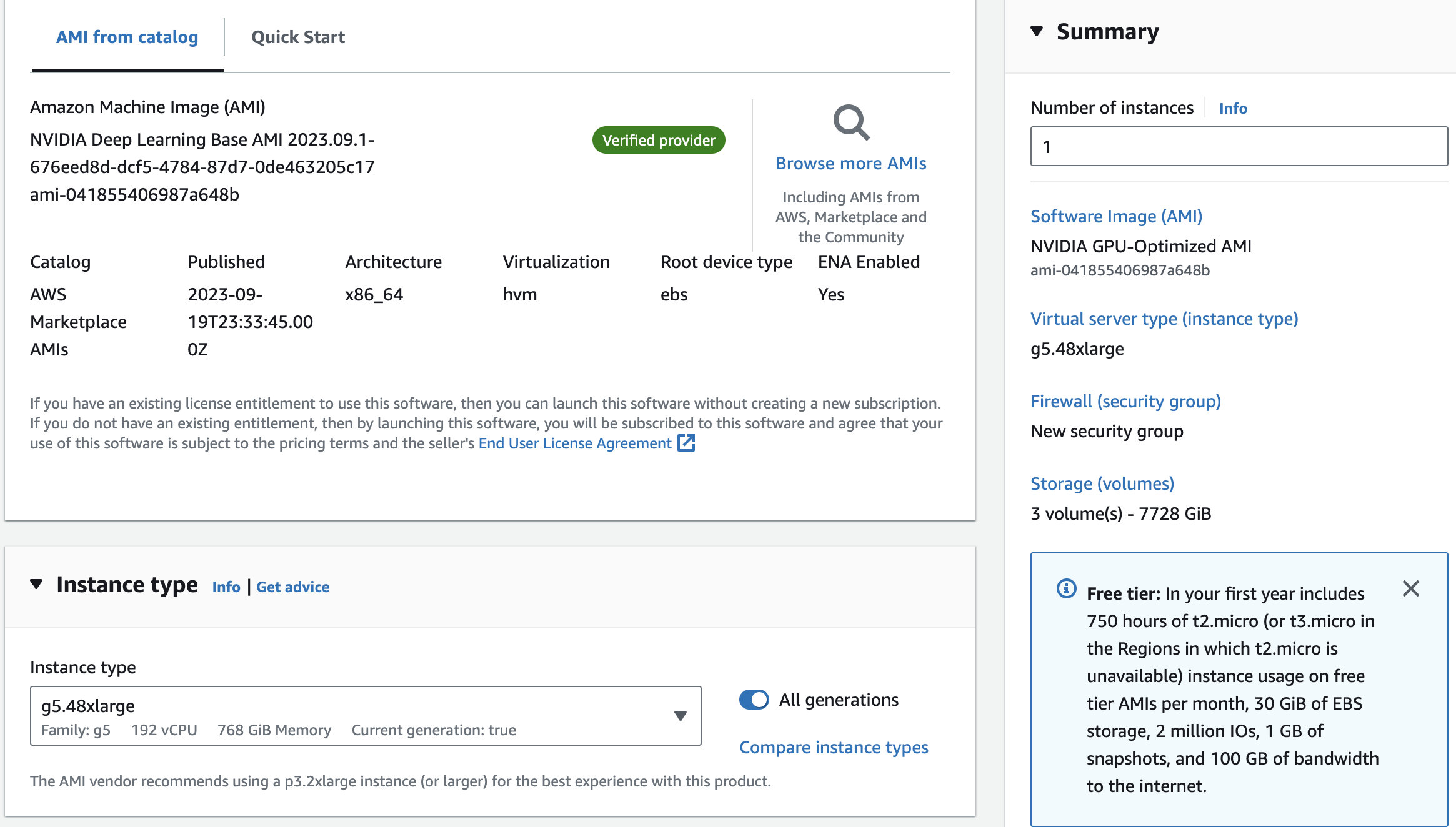

För närvarande kan Llama 3 laddas ner gratis från Metas webbplats i två olika parameterstorlekar: 8 miljarder (8B) och 70 miljarder (70B). Användare kan registrera sig för att få tillgång till dessa versioner. Llama 3 erbjuds i två varianter: pre-trained, som är en grundläggande modell för förutsägelse av nästa token, och instruction-tuned, som är finjusterad för att följa användarkommandon. Båda versionerna har en kontextgräns på 8 192 tokens.

I en intervju med Dwarkesh Patel nämnde Mark Zuckerberg, VD för Meta, att de tränade två specialbyggda modeller med ett 24,000 XNUMX-GPU-kluster. 70B-modellen tränades med cirka 15 biljoner tokens av data, och den nådde aldrig en mättnadspunkt eller en gräns för dess kapacitet. Därefter bestämde Meta sig för att fokusera på att träna andra modeller. Företaget avslöjade också att de för närvarande arbetar med en 400B-parameterversion av Llama 3, som experter som Nvidias Jim Fan tror kan prestera på samma sätt som GPT-4 Turbo, Claude 3 Opus och Gemini Ultra på riktmärken som MMLU, GPQA, HumanEval och MATH.

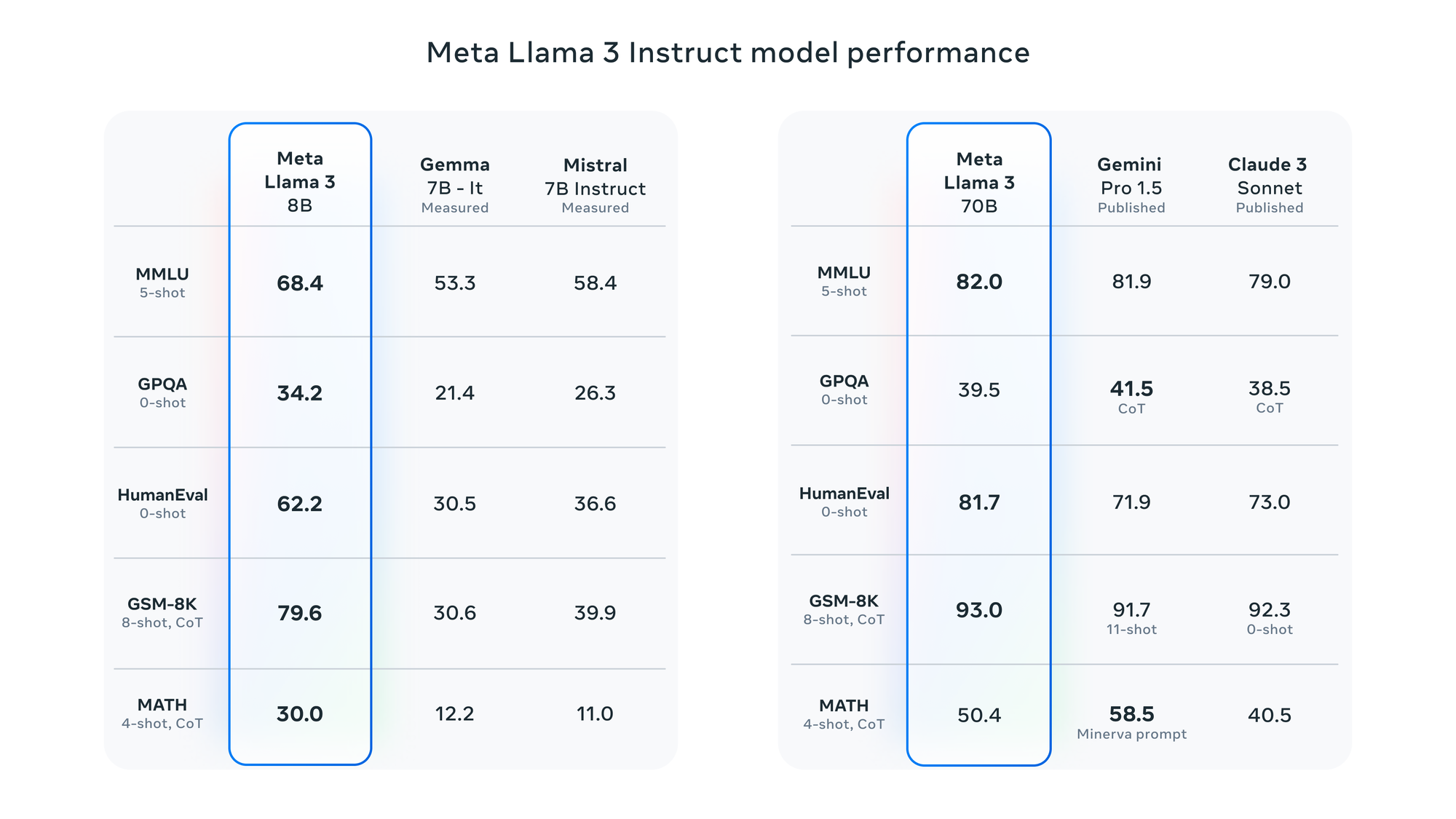

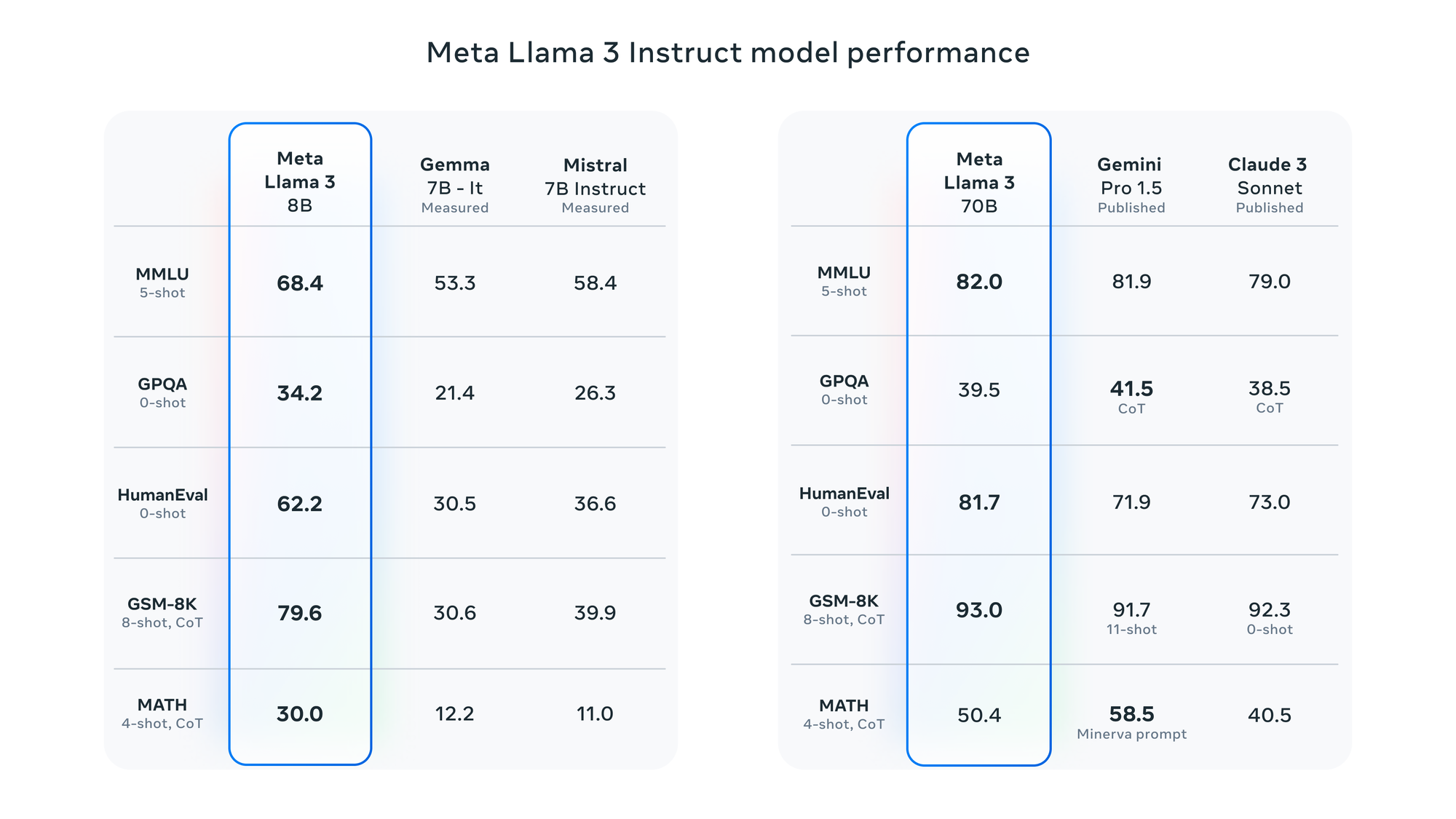

Enligt Meta har Llama 3 utvärderats med hjälp av olika benchmarks, inklusive MMLU (kunskap på grundnivå), GSM-8K (matematik på grundskolenivå), HumanEval (kodning), GPQA (frågor på avancerad nivå) och MATH (matematiska ordproblem). Dessa benchmarks visar att 8B-modellen överträffar modeller med öppna vikter som Googles Gemma 7B och Mistral 7B Instruct, och 70B-modellen är konkurrenskraftig mot Gemini Pro 1.5 och Claude 3 Sonnet.

Meta rapporterar att Llama 3-modellen har förbättrats med förmågan att förstå kodning, i likhet med Llama 2, och för första gången har den tränats med både bilder och text. Dess nuvarande utdata är dock begränsad till text.

LLaMA 3 riktmärken

LLaMA 3 riktmärken