GPT-NeoX 20B

GPT-NeoX 20B är den största öppen källkodsmodellen för behandling av naturliga språk i skrivande stund.

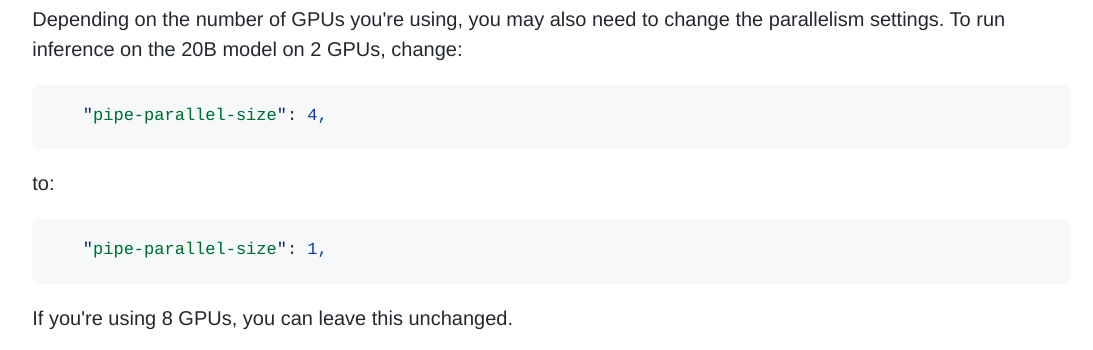

Den släpptes av EleutherAI för två veckor sedan. Den har tränats på 20 miljarder parametrar efter ett års hårt arbete med många utmaningar. En av deras största svårigheter verkade vara förmågan att sätta upp en ordentlig parallell arkitektur så att modellen kan tränas effektivt på flera GPU:er.

Deras tidigare modell, GPT-J, tränades på Googles TPU:er och utformades för att användas på TPU:er. GPT-NeoX 20B:s inre arkitektur är radikalt annorlunda och är gjord för att användas på GPU:er. Tanken är att den ska vara den första i en serie ännu större modeller (målet här är att komma ikapp GPT-3).

GPT-NeoX 20 är en modell för textgenerering, vilket innebär att den kan skriva text åt dig och faktiskt uppnå nästan alla användningsområden för Natural Language Processing med stor noggrannhet: generering av blogginlägg, chatbots, textklassificering, sentimentanalys, utvinning av nyckelord, kodgenerering, utvinning av entiteter, klassificering av intentioner, frågesvar och mycket mer...

Många forskare och företag kommer utan tvekan att utnyttja denna nya modell och få fantastiska resultat. Men det finns en utmaning: hur ska GPT-NeoX 20B användas?