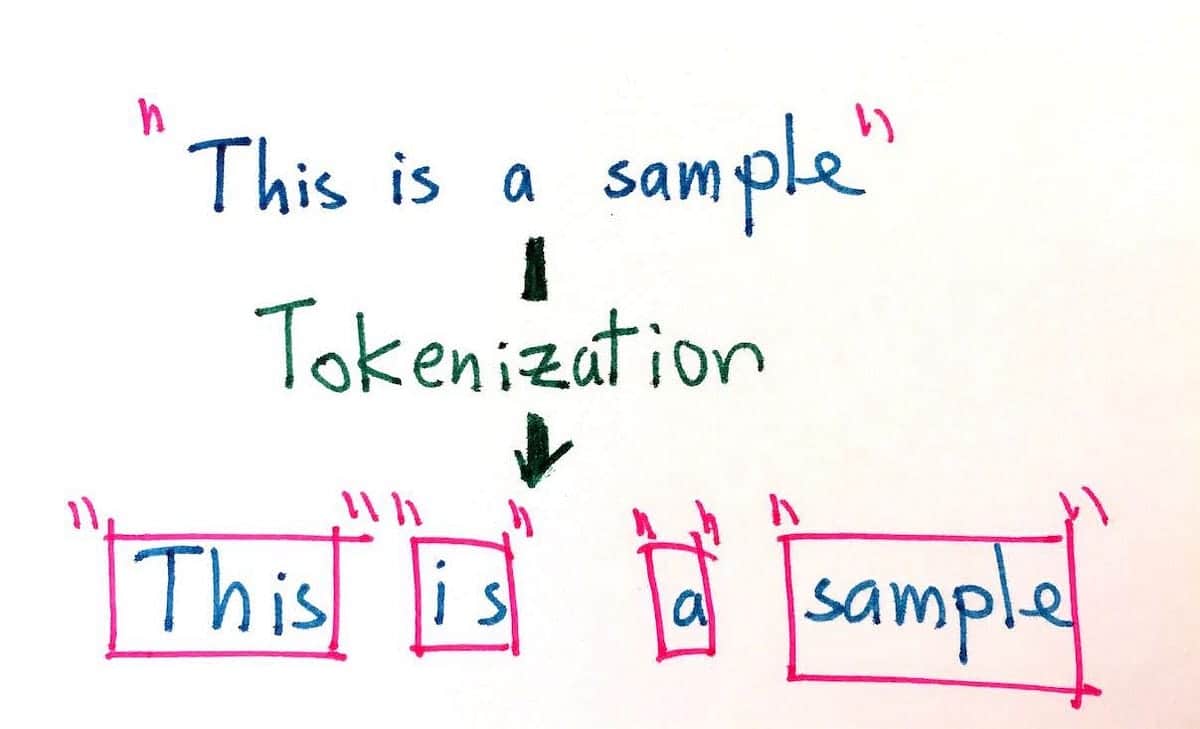

Vad är Tokenization?

Tokenisering handlar om att dela upp en text i mindre enheter som kallas tokens. Tokens är olika saker beroende på vilken typ av tokenizer du använder. En token kan antingen vara ett ord, ett tecken eller ett underord (t.ex. i det engelska ordet "higher", Det finns 2 underordnade ord: "high" och "er"). Skiljetecken som "!", "." och ";" kan också vara symboler.

Tokenisering är ett grundläggande steg i all bearbetning av naturligt språk. Med tanke på de olika språkstrukturer som finns skiljer sig tokeniseringen åt mellan olika språk.

Vad är lemmatisering?

Lemmatisering handlar om att extrahera grundformen av ett ord (vanligtvis den typ av arbete som du kan hitta i en ordlista). Till exempel skulle lemmat för "äpple" fortfarande vara "äpple" men lemmat för "är" skulle vara "vara".

Lemmatisering är, precis som tokenisering, ett grundläggande steg i all bearbetning av naturligt språk. Med tanke på de olika språkstrukturer som finns skiljer sig lemmatiseringen åt mellan olika språk.