Introduzione al LaMa 3

Meta ha presentato le prime versioni del modello di intelligenza artificiale open-source Llama 3, che può essere utilizzato per la creazione di testi, la programmazione o i chatbot. Inoltre, Meta ha annunciato l'intenzione di incorporare LLaMA 3 nelle sue principali applicazioni per i social media. Questa mossa mira a competere con altri assistenti AI, come ChatGPT di OpenAI, Copilot di Microsoft e Gemini di Google.

Come Llama 2, Llama 3 si distingue per essere un modello linguistico di grandi dimensioni liberamente accessibile con pesi aperti, offerto da un'azienda leader nel settore dell'intelligenza artificiale (anche se non si qualifica come "open source" nel senso convenzionale del termine).

Attualmente, Llama 3 può essere scaricato gratuitamente dal sito web di Meta in due diverse dimensioni di parametri: 8 miliardi (8B) e 70 miliardi (70B). Gli utenti possono registrarsi per accedere a queste versioni. Llama 3 è offerto in due varianti: pre-trained, che è un modello di base per la previsione del prossimo token, e instruction-tuned, che è ottimizzato per aderire ai comandi dell'utente. Entrambe le versioni hanno un limite di contesto di 8.192 token.

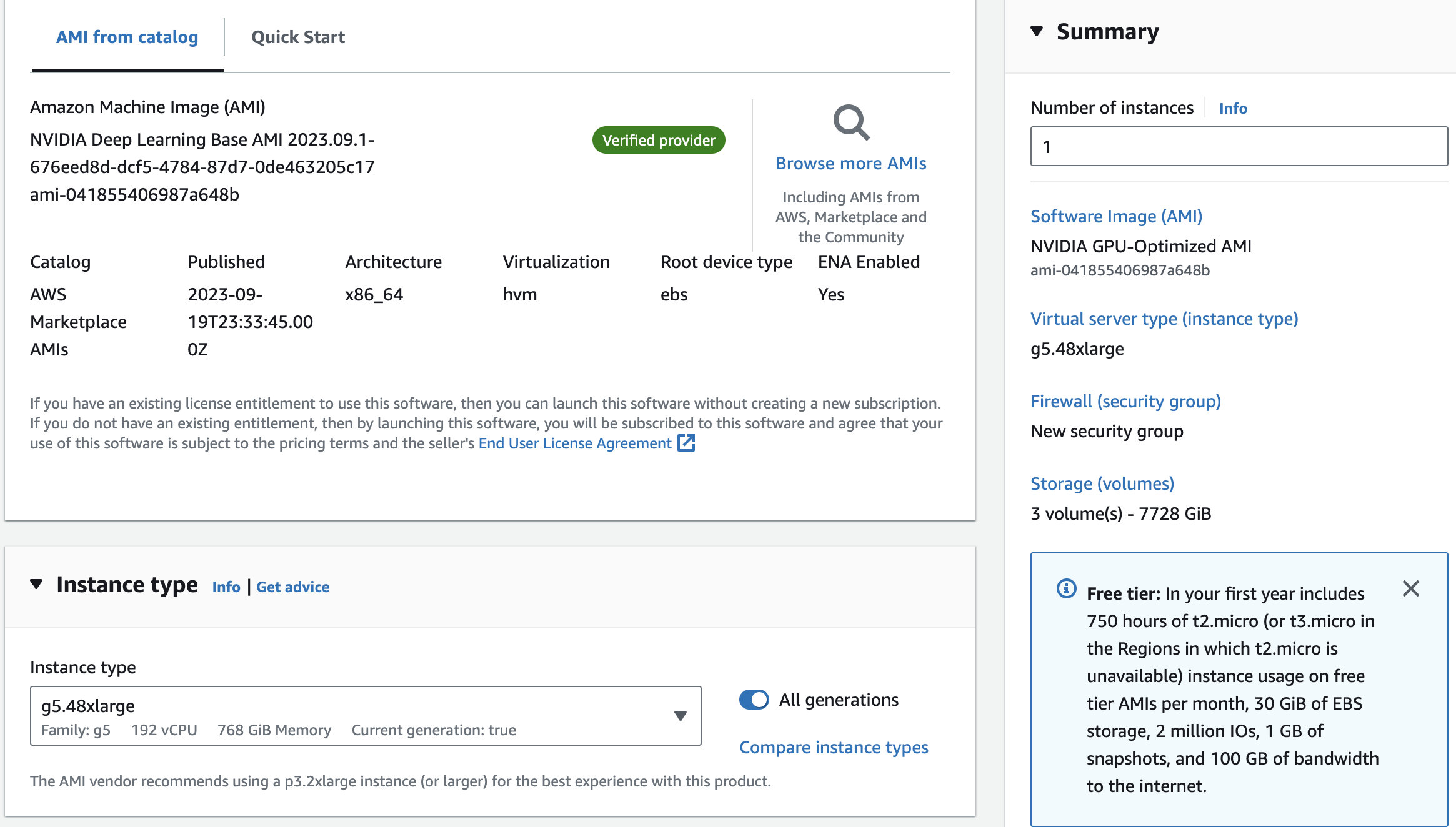

In un'intervista con Dwarkesh Patel, Mark Zuckerberg, CEO di Meta, ha dichiarato di aver addestrato due modelli personalizzati utilizzando un cluster di 24.000 GPU. Il modello 70B è stato addestrato con circa 15 trilioni di token di dati e non ha mai raggiunto un punto di saturazione o un limite alle sue capacità. In seguito, Meta ha deciso di concentrarsi sull'addestramento di altri modelli. L'azienda ha anche rivelato di essere attualmente al lavoro su una versione di Llama 3 con 400B parametri, che secondo esperti come Jim Fan di Nvidia potrebbe avere prestazioni simili a GPT-4 Turbo, Claude 3 Opus e Gemini Ultra su benchmark come MMLU, GPQA, HumanEval e MATH.

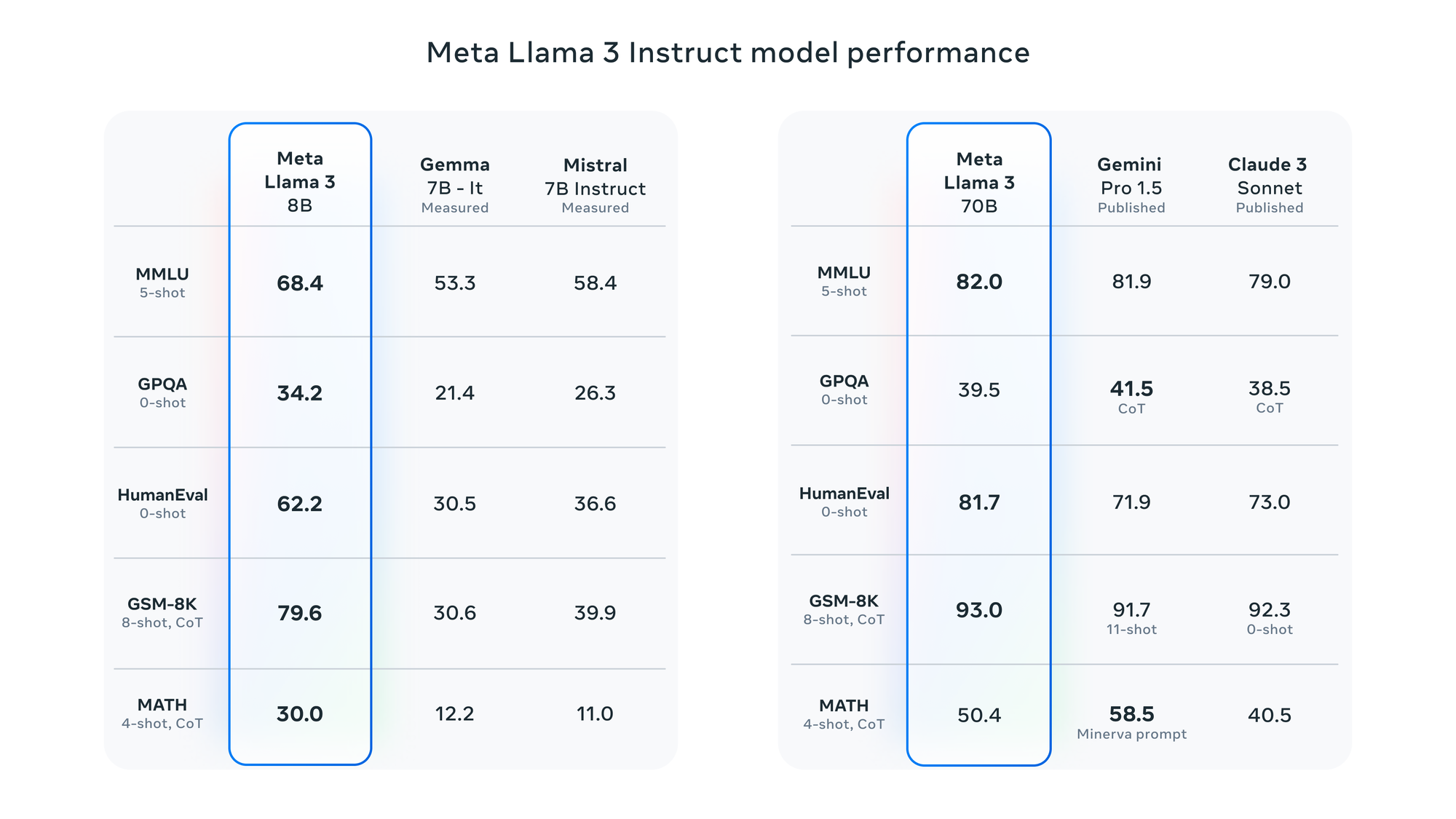

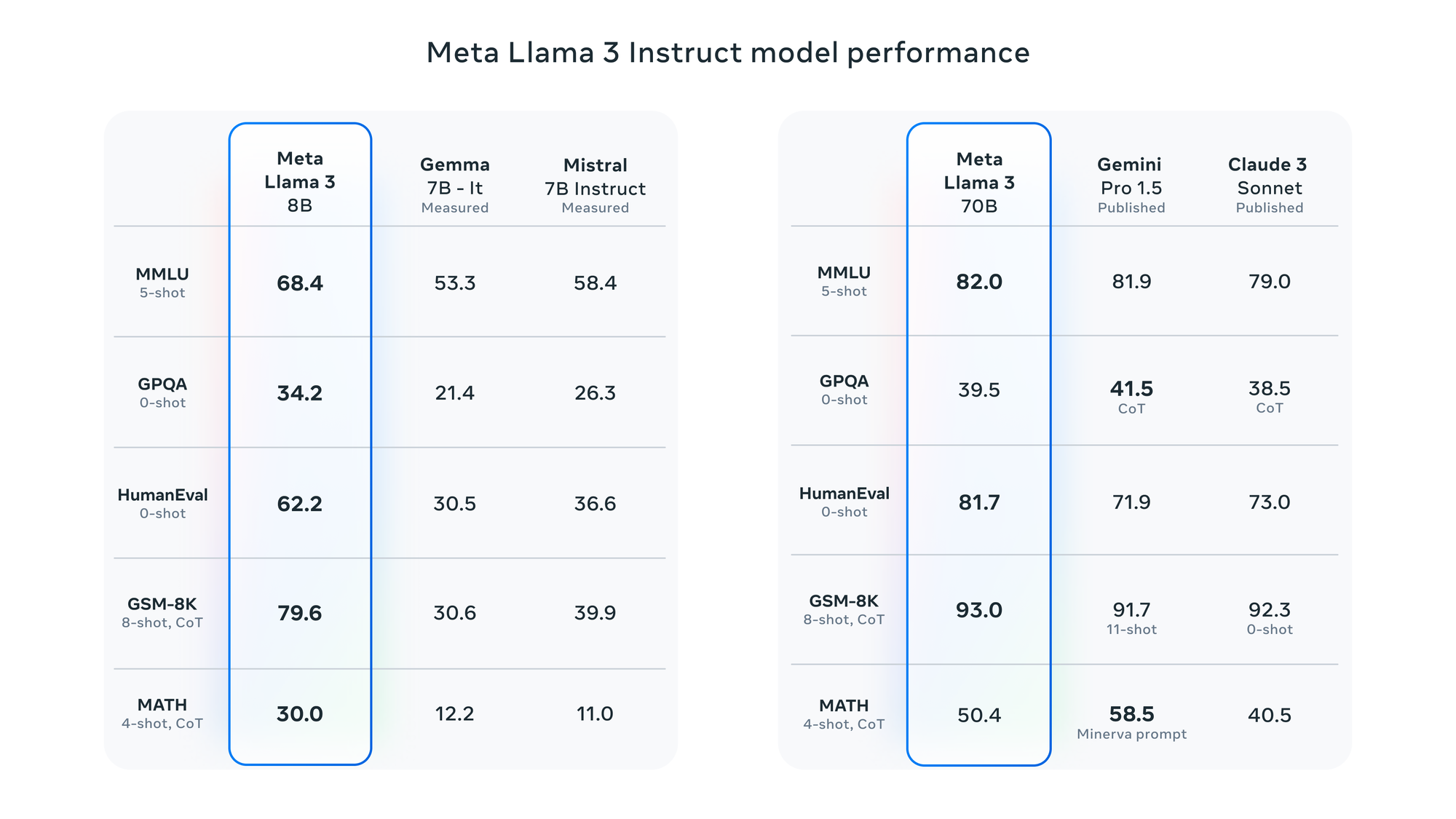

Secondo Meta, Llama 3 è stato valutato con diversi benchmark, tra cui MMLU (conoscenze a livello universitario), GSM-8K (matematica a livello elementare), HumanEval (codifica), GPQA (domande a livello universitario) e MATH (problemi di matematica). Questi benchmark dimostrano che il modello 8B supera i modelli a pesi aperti come Gemma 7B e Mistral 7B Instruct di Google, mentre il modello 70B è competitivo rispetto a Gemini Pro 1.5 e Claude 3 Sonnet.

Meta riferisce che il modello Llama 3 è stato migliorato con la capacità di comprendere la codifica, come Llama 2, e per la prima volta è stato addestrato utilizzando sia immagini che testo. Tuttavia, il suo output attuale è limitato al testo.

Parametri di riferimento LLaMA 3

Parametri di riferimento LLaMA 3