Estrazione di entità con apprendimento a pochi colpi

Ora eseguiremo l'estrazione di entità grazie all'apprendimento a pochi colpi.

Diciamo che volete estrarre i titoli di lavoro dai siti web. Date semplicemente un paio di esempi di estrazione di titoli di lavoro prima di fare la vostra richiesta effettiva:

Extract job titles from the following sentences.

Sentence: John Doe has been working for Microsoft for 20 years as a Linux Engineer.

Job title: Linux Engineer

###

Sentence: John Doe has been working for Microsoft for 20 years and he loved it.

Job title: none

###

Sentence: Marc Simoncini | Director | Meetic

Job title: Director

###

Sentence: Franck Riboud was born on 7 November 1955 in Lyon. He is the son of Antoine Riboud, who transformed the former European glassmaker BSN Group into a leading player in the food industry. He is the CEO at Danone.

Job title: CEO

###

Sentence: Damien is the CTO of Platform.sh, he was previously the CTO of Commerce Guys, a leading ecommerce provider.

Job title:

Il risultato sarà il seguente:

Extract job titles from the following sentences.

Sentence: John Doe has been working for Microsoft for 20 years as a Linux Engineer.

Job title: Linux Engineer

###

Sentence: John Doe has been working for Microsoft for 20 years and he loved it.

Job title: none

###

Sentence: Marc Simoncini | Director | Meetic

Job title: Director

###

Sentence: Franck Riboud was born on 7 November 1955 in Lyon. He is the son of Antoine Riboud, who transformed the former European glassmaker BSN Group into a leading player in the food industry. He is the CEO at Danone.

Job title: CEO

###

Sentence: Damien is the CTO of Platform.sh, he was previously the CTO of Commerce Guys, a leading ecommerce provider.

Job title: CTO

Come avete notato, dobbiamo essere intelligenti su come stiamo creando i nostri esempi di pochi colpi. Può succedere che non venga trovato nessun titolo di lavoro, ecco perché abbiamo creato un esempio che restituisce "nessuno" (evita i falsi positivi). Forse vuoi estrarre diversi titoli di lavoro allo stesso tempo? In questo caso è importante creare degli esempi che restituiscano anche diversi titoli di lavoro (titoli di lavoro separati da virgola, per esempio).

Otterrete risultati ancora migliori aggiungendo ancora più esempi. Ed è importante che i tuoi esempi siano il più vicino possibile alla tua richiesta finale effettiva. Per esempio, se sai che dovrai analizzare interi paragrafi invece di semplici frasi, è meglio creare esempi anche con paragrafi.

Se non hai accesso a un modello GPT, puoi semplicemente usare l'API NLP Cloud. Sono disponibili diversi client (Python, Go, Node.js, Ruby, PHP...). Mostriamo qui un esempio usando GPT-J con il client Python:

import nlpcloud

client = nlpcloud.Client("gpt-j", "your API token", gpu=True)

client.generation("""Extract job titles from the following sentences.

Sentence: John Doe has been working for Microsoft for 20 years as a Linux Engineer.

Job title: Linux Engineer

###

Sentence: John Doe has been working for Microsoft for 20 years and he loved it.

Job title: none

###

Sentence: Marc Simoncini | Director | Meetic

Job title: Director

###

Sentence: Franck Riboud was born on 7 November 1955 in Lyon. He is the son of Antoine Riboud, who transformed the former European glassmaker BSN Group into a leading player in the food industry. He is the CEO at Danone.

Job title: CEO

###

Sentence: Damien is the CTO of Platform.sh, he was previously the CTO of Commerce Guys, a leading ecommerce provider.

Job title:""",

top_p=0.1,

length_no_input=True,

remove_input=True,

end_sequence="###",

remove_end_sequence=True

)

Il risultato sarà: CTO

Lasciate che vi dia una rapida spiegazione sui parametri di generazione del testo che abbiamo appena usato.

Abbiamo impostato un valore p massimo molto basso perché non vogliamo che GPT-J crei risultati troppo originali: vogliamo solo che si attenga a ciò che ha visto nella tua richiesta.

"length_no_input" significa che il valore della lunghezza massima non deve tenere conto del testo inserito.

"remove_input" significa che il testo di input dovrebbe essere rimosso dal risultato.

"end_sequence" significa che quando il modello incontra questo carattere, dovrebbe smettere di generare testo. Poiché nei nostri esempi di pochi scatti abbiamo aggiunto "####" alla fine di ogni risposta, il modello genererà automaticamente "###" dopo aver generato la risposta e si fermerà lì.

"remove_end_sequence" significa che vogliamo rimuovere "###" dalla risposta.

Puoi vedere maggiori dettagli nella documentazione di NLP Cloud: vedere qui.

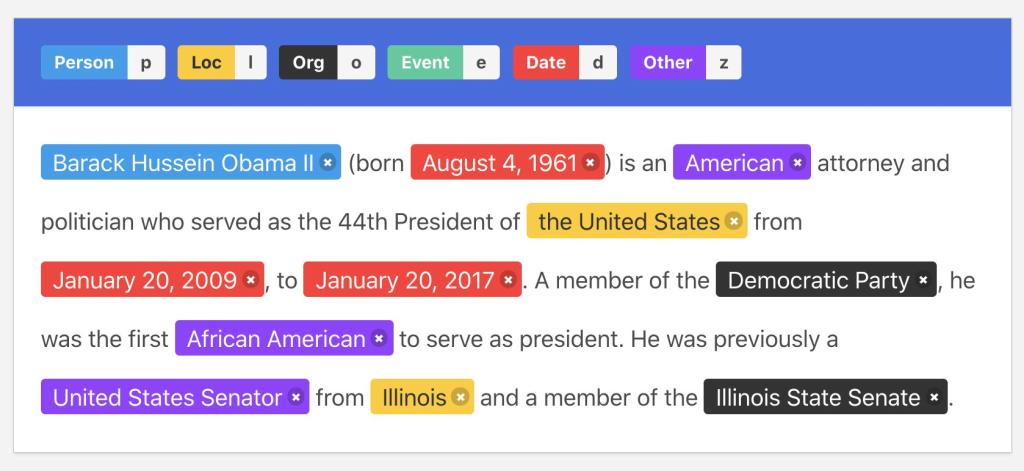

Illustrazione dell'annotazione

Illustrazione dell'annotazione