Multi-GPU с Deepspeed

Если вы не можете разместить свою модель на одном GPU, вы можете попробовать разделить ее на несколько GPU.

Это интересный вариант по двум причинам. Во-первых, горизонтальное масштабирование инфраструктуры часто обходится дешевле, чем вертикальное. Это верно для серверов, и это верно для GPU тоже. Во-вторых, легче получить в свое распоряжение несколько небольших GPU, таких как NVIDIA Tesla T4, чем большие GPU, такие как NVIDIA A40.

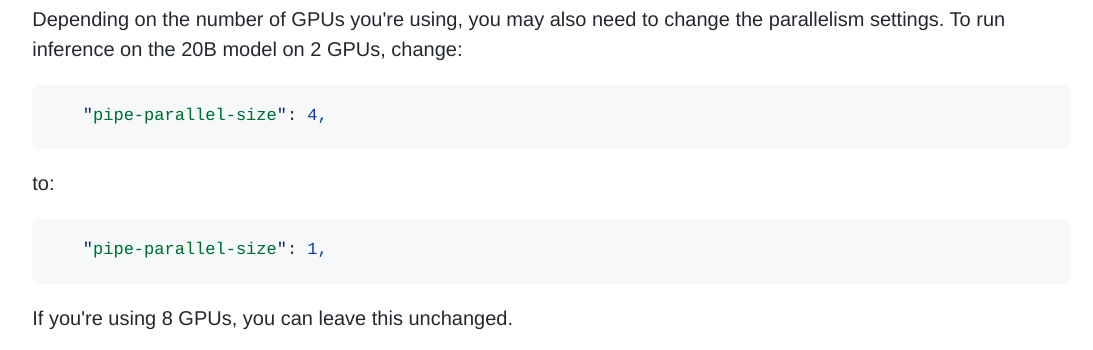

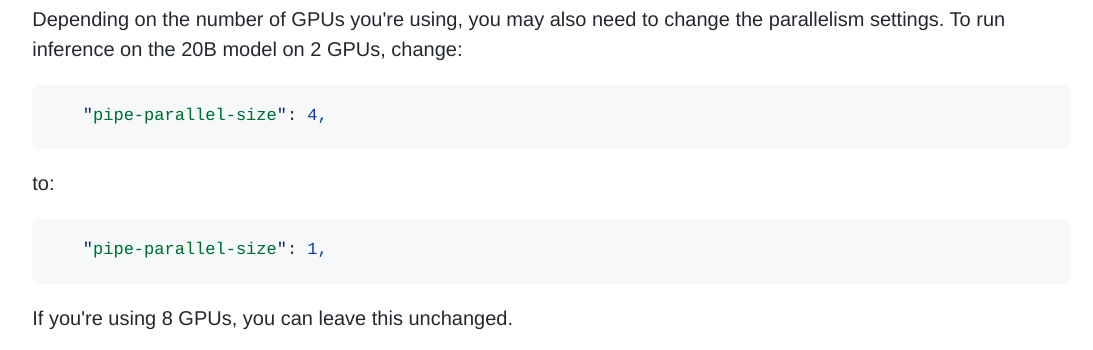

К сожалению, разделение модели машинного обучения на несколько GPU является сложной технической задачей. Hugging Face подготовил отличную статью о параллелизме моделей и выборе, который у вас есть. Читайте ее здесь. Но, к счастью, компания EleutherAI разработала GPT-NeoX 20B таким образом, что он легко распараллеливается на нескольких GPU, будь то обучение или вывод.

Архитектура GPT-NeoX основана на Deepspeed. Deepspeed - это фреймворк от Microsoft, который изначально был разработан для распараллеливания тренировок на нескольких GPU, но он все чаще используется и для выводов. EleutherAI проделала всю тяжелую работу, поэтому распараллелить GPT-NeoX так же просто, как изменить число в конфигурационном файле.

Extract from the GPT-NeoX docs about parallelism

Однако развернуть Deepspeed в производстве для онлайновых выводов через API сложно... Deepspeed не был разработан для легкой интеграции в веб-серверы. В NLP Cloud мы узнали об этом нелегким путем, но после напряженной работы нам наконец удалось придумать эффективный способ заставить Deepspeed и GPT-NeoX работать с нашим API.